GPT-5 marque la maturité d'OpenAI

OpenAI présente trois nouveaux modèles d'IA • Souveraineté : l'Europe doit miser sur les usages et l'adoption • Bain décrit la future vague de la robotique IA • Veo 3 et les deepfakes : réussirez-vous le test de l'été ? • Bienvenue dans Qant, vendredi 8 août 2025.

« Le progrès est devant nous, à condition de dépasser sa propagande » Paul Virilio

••• L’essentiel de l’actual-été, décrypt-étée •••

••• L’essentiel de l’actual-été, décrypt-étée •••

OpenAI consolide son avance

L’annonce de GPT-5 n’aura pas le retentissement de celle de GPT-4, il y a deux ans. Mais elle montre comment, face à la maturité de l’IA générative, OpenAI se construit un “fossé”.

Un expert dans la poche. Le but annoncé de la série de modèles GPT-5 est de permettre à chacun d’interroger à tout moment un expert de haut niveau : en droit, en finance, en santé, en programmation... Disponible, à des degrés divers, jusque dans la formule gratuite, GPT-5 préfigure une nouvelle interface d’accès à la connaissance et au divertissement, où l’utilisateur demande à la machine de se coder elle-même. Le nouveau monde numérique, qui succède à celui dominé par Apple, AWS et ARM, commence à se dessiner.

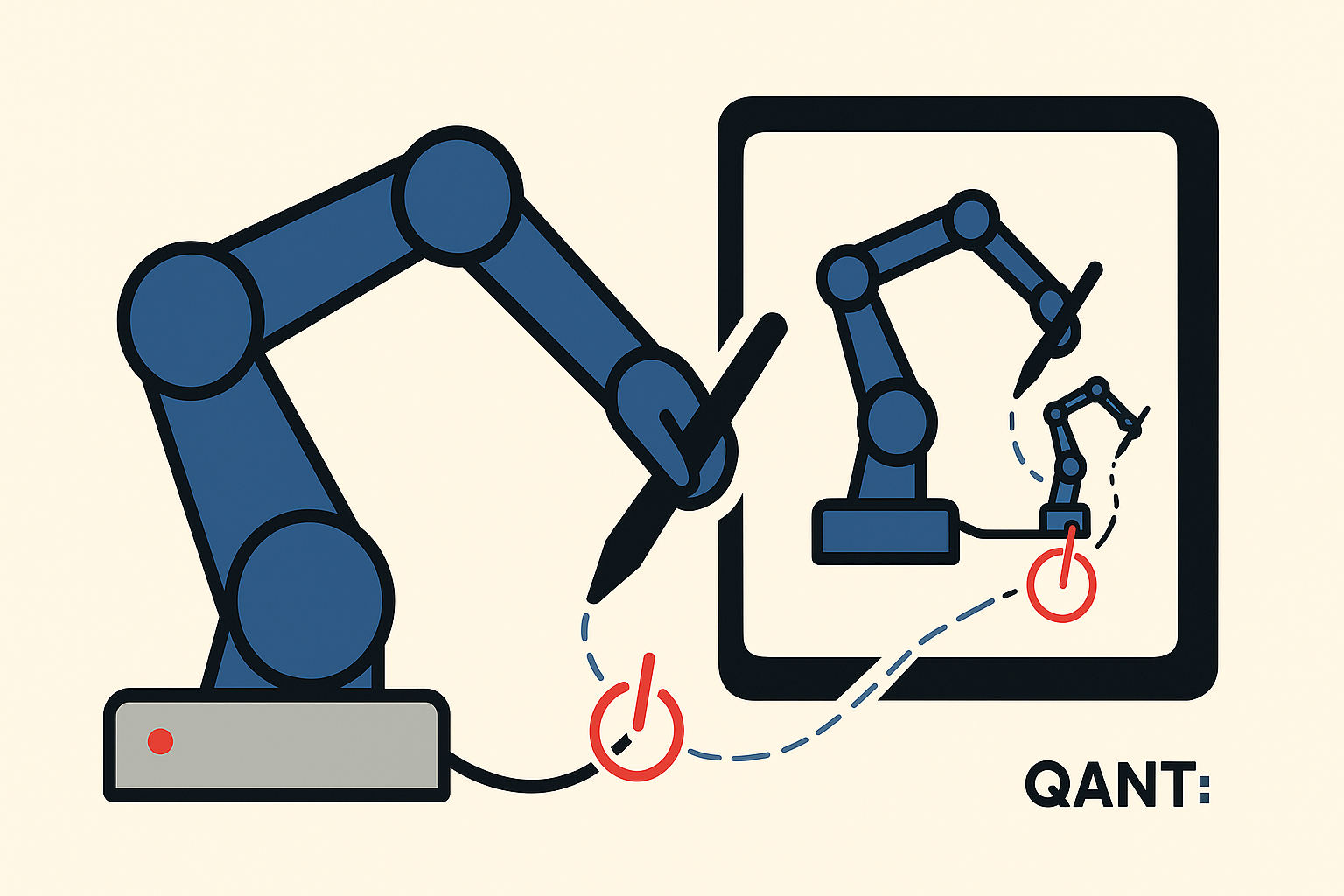

« Ideal pair programmer » : dans l’immédiat, GPT-5 est présenté comme la paire idéale pour chaque codeur – une méthode de programmation qui revient à la mode grâce à l’IA, où un programmeur (aujourd’hui l’IA) écrit le code et l’autre commente, corrige et vérifie. Comme Claude d'Anthropic, GPT-5 dispose en outre d’un agent capable de travailler sur de longues durées et d’appeler plusieurs outils pour exécuter la tâche que lui confie l’utilisateur. Le grand public – et les journalistes – ont été appelés à faire coder un petit programme ludo-éducatif (non pas un serpent, mais une souris) mais l’interface semble aussi prête à générer des graphiques interactifs de visualisation de données, avec une utilisation de Python minimisée par l’utilisateur. Pour faire bon poids, OpenAI a tenté de faire oublier l’échec des négociations avec Windsurf en faisant monter sur scène Michael Truell, fondateur de l’environnement de développement rival, Cursor.

• « GPT-5 a été capable d’identifier nos choix d’architecture et comprendre pourquoi nous les avions faits » s’étonnait hier Michael Truell, fondateur de Cursor : « Notre équipe a trouvé que GPT-5 était remarquablement intelligent, facile à piloter et qu’il avait même une personnalité que nous n’avons vue dans aucun autre modèle. Il détecte non seulement les bogues complexes et profondément cachés, mais il peut également exécuter des agents d’arrière-plan longs et à plusieurs tours pour mener à bien des tâches complexes, le genre de problèmes qui bloquaient auparavant les autres modèles »

Montée en puissance indirecte. Abandonnant vraisemblablement la course à la taille, GPT‑5 se base une architecture multi‑modèles avec une IA spécifique pour router la demande de l’utilisateur, sur un corpus d’entraînement gardé secret – sans doute à cause des problèmes de copyright d’OpenAI – mais présenté comme rigoureusement filtré. Surtout, OpenAI renforce la sécurité, réduit les hallucinations, améliore le raisonnement et, plus généralement, optimise ses modèles pour les trois principaux cas d’usage : l’écriture, les conseils de santé, le code.

Architecture unifiée. La carte‑système décrit un modèle rapide (gpt‑5‑main), un modèle de raisonnement profond (gpt‑5‑thinking), des modèles sans doute distillés (mini et nano) et un routeur temps réel qui dirige dynamiquement la requête vers le bon composant. Cette conception parallélise le calcul : le modèle « rapide » sert la majorité des requêtes tandis que le modèle « pensant » ne s’active que sur les tâches complexes ou sur demande explicite (“think hard”). L’IA-routeur est formée en continu sur les retours utilisateurs.

Paramètres flous. OpenAI ne divulgue aucun compte exact de paramètres pour GPT‑5. Les besoins matériels se reflètent surtout dans le partenariat prolongé avec Microsoft Azure : la formation mobilise des grappes de H100 et GB200 de Nvidia, ainsi que des pipelines de données multitéraoctets, signalant une échelle nettement supérieure à GPT‑4o.

Données sous contrôle. Les modèles s’appuient sur un corpus massif mais filtré de données publiques, partenariales et soumises par les utilisateurs ; un double contrôle par la modération OpenAI et des classifieurs de sécurité écarte les informations personnelles et les contenus nuisibles. Il s’agit là d’une tendance générale : Grok, par exemple, s’est engagé dans une refonte de son corpus pour en éliminer toutes les références “woke” récupérées sur Internet, qui le conduise à donner des réponses contraires à la ligne qu’Elon Musk veut donner à X.

Sécurité proactive. Une méthode de sécurité baptisée « safe‑completions » traite les requêtes sensibles dans le cadre de la politique de contenu et produit des réponses utiles plutôt qu’un refus automatique.

Moins d’erreurs. La version gpt‑5‑main affiche 26 % d’erreurs factuelles en moins que GPT‑4o et 44 % de réponses contenant une erreur majeure en moins ; gpt‑5‑thinking réduit de 65 % les hallucinations et de 78 % les erreurs majeures par rapport à OpenAI o3.

Raisonnement turbo. Des chaînes de raisonnement internes plus longues, un entraînement contre la “sycophancie” et une anticipation des besoins améliorent l’objectivité, la fiabilité et la rapidité des réponses.

Prix agressivement bas. OpenAI propose GPT-5 un peu moins cher que GPT-4o (1,25 dollar par million de tokens en input, et les mêmes 10$ en output), et donc considérablement moins cher que les autres grands modèles du marché (Claude Opus 4.1, le plus utilisé dans la génération de code, coûte 15 dollars en entrée et 75$ en sortie).

Open source et open weights. Par ailleurs, OpenAI vient de publier GPT‑OSS‑120B (116,8 milliards de paramètres, dont 5,1 Md actifs) et 20B (20,9 Md, 3,6 Md), deux transformeurs autorégressifs MoE (mélange d’experts) de 36 / 24 couches avec 128 / 32 experts. Le but, à peine déguisé, est d’occuper le terrain : sinon contrer le futur DeepSeek R2, la deuxième génération du puissant modèle chinois , du moins ne pas abandonner aux non-Américains le terrain des modèles ouverts, après l’échec de Llama 4 de Meta.

À SURVEILLER : Pas d’AGI, mais un routeur auto‑apprenant… Et une nouvelle valorisation. L’intelligence artificielle générale (AGI) n’a pas été citée dans la présentation de GPT-5 : ces nouveaux éléments de langage montrent qu’OpenAI, confrontée au point culminant des effets d’échelle, se concentre sur son emprise sur le marché de l’IA grand public, contre Google, et dans une moindre mesure professionnelle (ce qui génère de fortes tensions avec Microsoft). Le routeur auto-apprenant devra se révéler une innovation suffisamment convaincante pour permettre à Sam Altman de mener à bon port une cession secondaire d’actions à Thrive Capital, sur la base d’une nouvelle valeur d’entreprise de 500 milliards de dollars, ce qui en fera la première entreprise non cotée au monde.

••• Les plus folles images de l’IA •••

••• Les plus folles images de l’IA •••

Les superpouvoirs de Veo 3

De faux JT et un test.

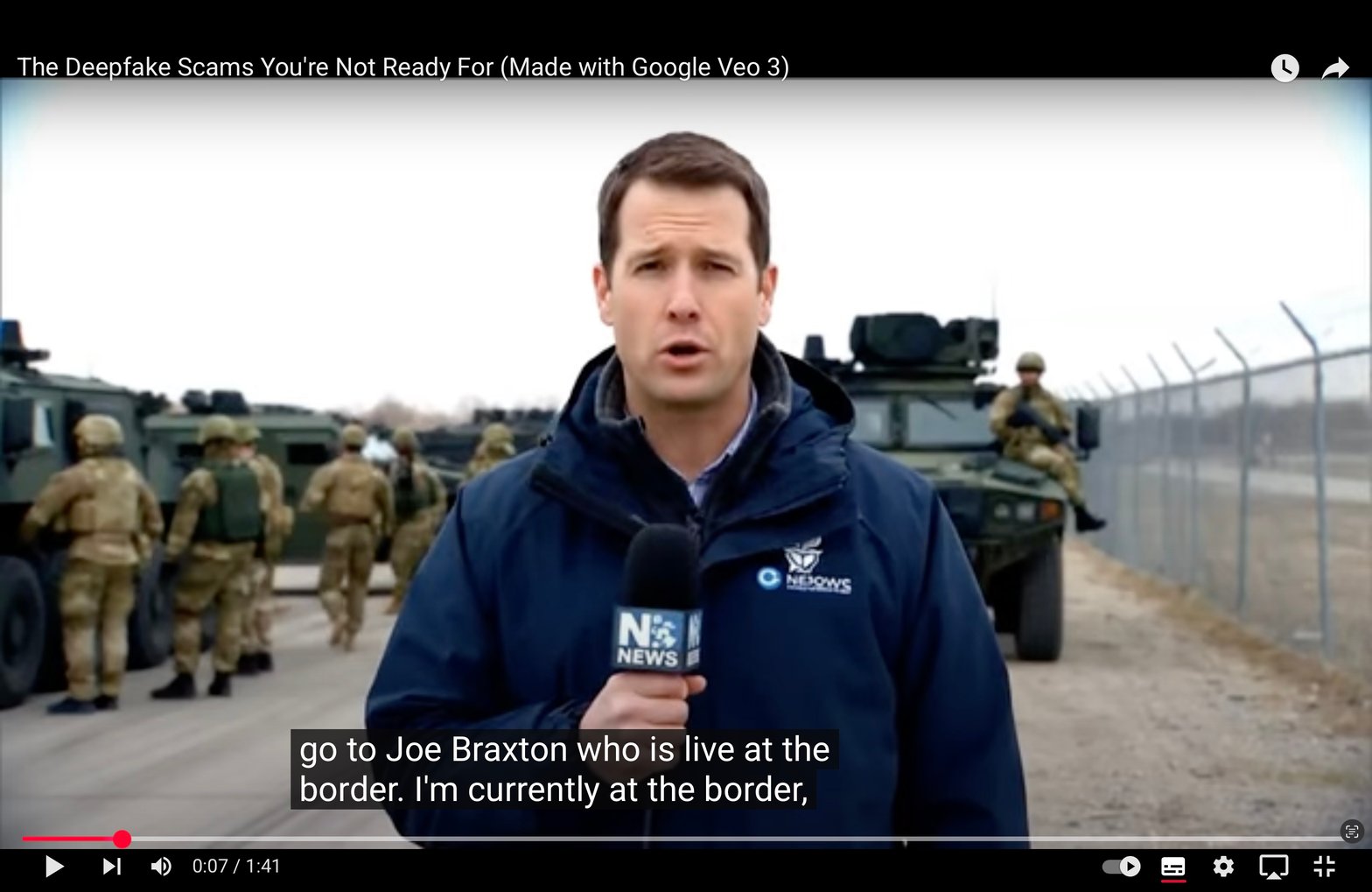

Présenté en mai dernier par Google, le modèle Veo 3 est devenu disponible presque partout dans le monde pendant l’été. Euronews a dénoncé, vendredi dernier, la recrudescence de fausses émissions d’information, de plus en plus réalistes.

Dès la sortie de Veo 3, le cinéaste américain Travis Bible a créé avec le modèle une courte vidéo de mise en garde, vue plus de 25 millions de fois sur diverses plates-formes, qui commence précisément par une séquence d’information sur un événement spectaculaire : le Canada qui déclare la guerre aux États-Unis de Donald Trump.

Veo 3 représente l’état de l’art en génération vidéo par IA en 2025. Il permet de créer des vidéos 1080p d’environ 8 secondes avec du son à partir d’une simple requête textuelle. Entraîné en regardant de vastes bases de données vidéo, notamment Youtube, ce modèle de diffusion latente et intègre directement le watermarking SynthID dans chaque clip généré. Celui-ci cependant n’est pas aisément détectable, alors que les marquages apparents sont facilement éliminés.

« Google a mis des filigranes cachés sur les vidéos et images générées par l’IA afin qu’on puisse les détecter. Mais si Google en est déjà là, on verra arriver d’ici la fin de l’année des modèles open source qui, eux, n’auront pas ces filigranes. » • Alejandra Caraballo, Harvard Law School

Les caractéristiques techniques principales de Veo3 incluent la génération audio native (Veo 3 crée automatiquement les voix, dialogues, bruitages ambiants et effets sonores correspondant à la scène décrite), une synchronisation labiale et gestuelle réaliste (les personnages générés bougent les lèvres en parfaite cohérence avec le discours et adoptent des mouvements corporels naturels, réduisant les indices artificiels), une physique crédible (les lois de la physique sont respectées dans la gravité, les éclairages et les textures, ce qui donne aux vidéos une apparence filmée caméra au poing dans le monde réel) et des prompts multi-entrées : l’utilisateur peut fournir une description textuelle détaillée, voire une image de référence, et Veo 3 composera la scène correspondante. Par exemple, « Générer un présentateur TV britannique annonçant un naufrage avec un ton dramatique » produira directement la vidéo correspondante en quelques minutes .

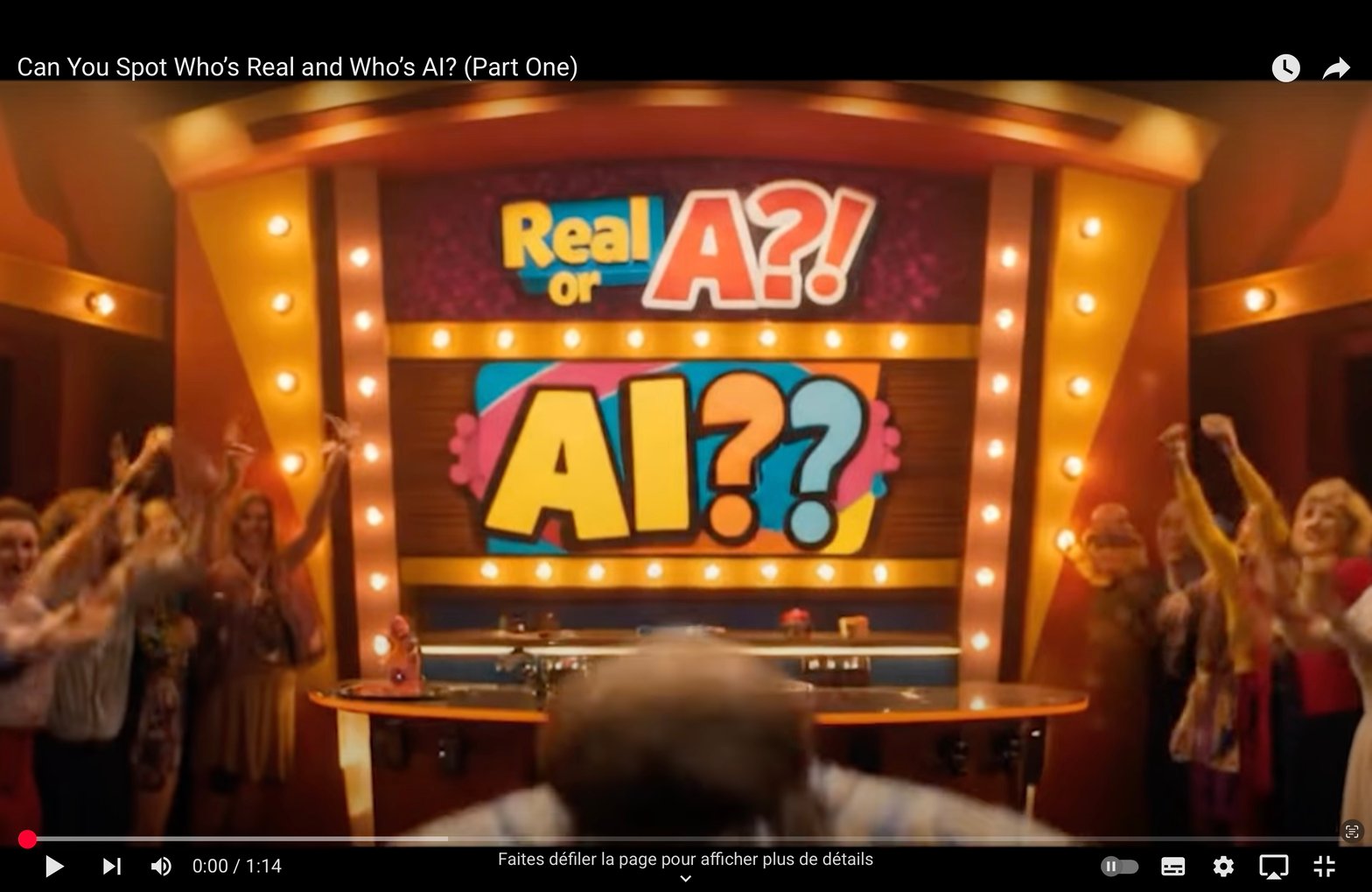

Travis Bible a créé un jeu d’été, Real or AI ?, qui propose de distinguer les séquences réelles des séquences générées par IA. À vous de jouer :

EN EXCLUSIVITÉ POUR LES ABONNÉS :

EN EXCLUSIVITÉ POUR LES ABONNÉS :

• Souveraineté : Alors que la bataille pour la suprématie dans l’intelligence artificielle semble se jouer exclusivement entre Washington et Pékin, l’Europe, souvent perçue comme un simple spectateur, pourrait détenir la clé de la victoire à long terme. Le véritable enjeu n’est pas tant d’inventer la technologie que de la diffuser. En misant sur une adoption massive de l’IA au sein de son tissu économique, notamment par ses PME, plutôt que sur la course à la dernière innovation, le Vieux Continent peut transformer son retard en avantage stratégique.

• Usages : Selon un rapport de Bain, les robots humanoïdes, dopés à l’intelligence artificielle et à la baisse des coûts, approchent une viabilité économique inédite.

Pour une nouvelle stratégie de l'Europe en matière d'IA

Par Edoardo Campanella

Prise en étau entre les géants américains et chinois de l’IA, l’Europe semble condamnée à regarder passer le train de la quatrième révolution industrielle. Pourtant, cette position de suiveur pourrait se muer en atout maître si l’Europe se concentre sur l’essentiel : irriguer massivement son économie avec l’intelligence artificielle existante. Des machines à vapeur aux microprocesseurs, ce ne sont jamais les inventeurs, mais les diffuseurs qui remportent les révolutions industrielles sur le long terme. Reste à voir si l’Union européenne saura troquer sa passion de la réglementation contre une stratégie d’adoption pragmatique, transformant ses PME en fer de lance d’une compétitivité retrouvée face aux mastodontes sino-américains.

La « course à l'IA » mondiale semble désormais réduite à un affrontement frontal entre la Chine et les États-Unis. Même si des déficiences structurelles bien connues empêchent l'Europe de développer ses propres géants de l'IA et d'être à l'origine d'innovations majeures, elle pourrait toutefois encore remporter la course à long terme en favorisant la diffusion des technologies d'IA dans l'ensemble de son économie.

Quatrième révolution industrielle

...