Grok 4 ne noie pas le poisson de la propagande

Le navigateur de Perplexity devance celui d'OpenAI • Elon Musk lance Grok 4 sans faire oublier les polémiques • Pluie d’or sur les start-up d’IA • Xpanceo relance les lentilles connectées • Hugging Face embrasse un nouveau robot • La Russie, les cryptos et les sanctions • Dans l’ombre, DeepSeek avance • Bienvenue dans Qant, jeudi 10 juillet 2025.

« Le progrès est devant nous, à condition de dépasser sa propagande » Paul Virilio

Deux comètes dans le ciel des navigateurs

Deux comètes dans le ciel des navigateurs

Hier soir, Perplexity a ouvert son navigateur IA, Comet, pendant que Reuters obtenait des précisions sur le futur navigateur d’OpenAI.

OpenAI lancera son propre navigateur dans les prochaines semaines, d’après l’agence Reuters. Dérivé de l’app ChatGPT, il devrait proposer une interface conversationnelle, ce qui tendrait à dissuader les utilisateurs de sortir de ChatGPT, et intégrer des agents d’IA pour automatiser certaines tâches, comme le remplissage de formulaires ou les réservations. Il fera levier sur les 500 millions d’utilisateurs hebdomadaires de ChatGPT pour obtenir rapidement une masse critique.

Pour sa part, Perplexity a ouvert hier son navigateur Comet à ses abonnés Max. Un assistant d’IA contextuel, intégré au navigateur, permet de résumer ou de “dialoguer” avec le contenu de la page ou du mail affiché. Comet Assistant peut également gérer les onglets ouverts et les événements dans l’agenda de l’utilisateur. Le moteur de recherche de Perplexity est préinstallé dans le navigateur.

L’ENJEU : Les données de l’utilisateur. Google a fait de Chrome, et des données qu’il collecte, un pilier de la personnalisation des publicités, qui génèrent les trois quarts de son chiffre d’affaires. Pour tenter de se défendre contre l’offensive d’OpenAI et de quelques autres – outre Perplexity, on peut citer Arc et Opera –, le géant a commencé à déployer Gemini dans toute son offre.

Grok 4

Grok 4

Présentée cette nuit, la nouvelle version de Grok ne suffit pas à détourner l’attention de la démission de la directrice générale de X et des comportements déviants de la version précédente. Presque dommage.

Démissions. Confrontés à une polémique croissante sur les dérives de Grok, le chatbot de X, la directrice générale du réseau social Linda Yaccarino et le directeur scientifique de xAI, Igor Babuschkin ont présenté leur démission hier, peu avant qu’Elon Musk ne présente le nouveau Grok 4.

Petit nouveau. Selon Elon Musk – sans qu’aucune preuve technique indépendante ne vienne appuyer l’affirmation –, Grok 4 est conçu pour générer des réponses basées sur des principes fondamentaux plutôt que sur la reconnaissance de motifs issus des données d'entraînement, par proximité vectorielle. Cela résulterait, le cas échéant, en des explications plus robustes et originales, particulièrement pour les sujets techniques, une plus grande cohérence logique et des capacités analytiques plus approfondies.

Grok codeur. Une variante spécialisée, Grok 4 Code, s’intègre à des environnements de développement et des éditeurs IA, comme Cursor. Un éditeur natif s’inspirera de Visual Studio pour permettre un "codage agentique" plus autonome, où l'IA peut écrire, modifier et déboguer du code directement sans que les développeurs ne quittent l'interface Grok, sur l’offre Grok4Heavy (ou l’API avec exécution de fonctions).

Grok contexte. Le modèle dispose d'une fenêtre d’attention de 256 000 tokens, permettant des conversations étendues et une analyse approfondie de documents ou de bibliothèques de code. Grok4 se hisse ainsi au-dessus de ses principaux rivaux : Claude 4 et o3 n’offre que 200 000 jetons de contexte. Personne n’égale, toutefois, Gemini 2.5 Pro et Flash, avec 1 million de tokens.

Grok scores. Le modèle Heavy, doté d’outils, aurait obtenu 45% au benchmark difficile "Humanity's Last Exam" (HLE) – plus du double du précédent meilleur score, de Gemini 2.5 Pro – ; 95 % sur AIME 2025 (mathématiques avancées) ; 73% sur SWE-Bench (codage) et 89% sur GPQA (raisonnement niveau licence).

Vision tardive. Grok 4 est présenté comme multimodal, pouvant accepter plusieurs types d'entrée, incluant le texte et les images, avec des fonctionnalités de génération d'images et de traitement visuel. Mais seul le texte est pour l’instant disponible à tous ; la vision est limitée à l’API.

EN FILIGRANE : MechaHitler, malvenu en Pologne et rejeté en Turquie. xAI a supprimé hier des contenus publiés par son chatbot Grok après que celui-ci ait fait l’éloge d’Adolf Hitler en réponse à des questions orientées, et qu’il se soit attribué lui-même le surnom “MechaHitler”. Presque simultanément, le ministre polonais du Numérique, Krzysztof Gawkowski, a déclaré publiquement qu’il était prêt à interdire X si les injures que le chatbot profère régulièrement envers des politiciens modérés, comme le Premier ministre Donald Tusk, s’avéraient enfreindre la loi. Plus expéditive, la Turquie a bloqué hier l’accès au chatbot, dans l’attente des résultats d’une enquête sur des insultes proférées en direction de Mahomet, le fondateur de la république Mustafa Kemal Ataturk et son président actuel, Recep Tayip Erdogan.

À SURVEILLER : Un problème de crédibilité. Pour réduire les dérives, Musk affirme avoir fait diminuer la sensibilité de Grok aux prompts qu’il reçoit sur le réseau social. Il veut également “diminuer la dépendance aux médias mainstream”, en entraînant Grok 4 pour qu’il évite de s'appuyer sur des affirmations non vérifiées et reste sceptique face aux biais médiatiques. Il souhaite même "réécrire l'ensemble du corpus de connaissances humaines" pour éliminer les biais et améliorer la précision factuelle. En attendant, malgré la conception de la “liberté d’expression” affichée par son chef, xAI a annoncé avoir renforcé les filtres qui empêchent Grok de donner des réponses haineuses. Précisément ce que font OpenAI, Google et Anthropic.

Des capitaux records pour l’IA

Des capitaux records pour l’IA

Malgré un fléchissement par rapport au début de l’année, le capital-risque mondial a atteint 91 milliards de dollars au deuxième trimestre, porté par des méga-tours de table dans l’intelligence artificielle.

Le capital-risque mondial a investi 91 milliards de dollars au deuxième trimestre 2025, en hausse de 11 % sur un an, mais en baisse de 20 % par rapport au premier trimestre, selon Crunchbase.

Près de 45 % des fonds du trimestre, soit 40 milliards de dollars, ont été levés dans le secteur de l’intelligence artificielle, dont 14,3 milliards pour Scale AI.

Les tours supérieurs à 500 millions ont concentré près d’un tiers des capitaux, 16 entreprises ayant levé des montants records, comme Anduril Industries (2,5 milliards) ou Thinking Machines (2 milliards).

Les États-Unis ont capté 60 milliards de dollars, soit les deux tiers des fonds levés dans le monde, concentrés sur les plus grandes entreprises.

EN FILIGRANE : OpenAI, acquéreur stratégique. Les fusions-acquisitions ont généré 50 milliards de dollars en valeur de sortie, avec OpenAI comme principal acquéreur, incluant io (6 milliards) et Windsurf (3 milliards).

À SURVEILLER : La concentration des méga-rounds renforce l’écart entre les très grandes levées de fonds, notamment dans l’IA, et les financements accordés aux jeunes pousses et phases précoces d’autres technologies émergentes.

Big Blue, small AI ?

Big Blue, small AI ?

IBM présente ses nouveaux serveurs Power11, conçus pour une meilleure efficacité énergétique et, en intégrant l’accélérateur Spyre, un déploiement simplifié de l’intelligence artificielle dans les entreprises.

IBM a présenté ses nouveaux serveurs Power11. Cette première mise à jour majeure de la gamme Power depuis 2020 vise à surpasser en efficacité énergétique les systèmes x86 équivalents.

IBM met en avant la détection de ransomware en moins d’une minute grâce à la fonctionnalité Power Cyber Vault, ainsi que l’intégration de Watsonx Code Assistant et du data lakehouse Watsonx.data d’ici fin 2025.

Disponibles le 25 juillet prochain, les Power 11 affichent un taux de disponibilité de 99,9999 %, soit moins de 30 secondes d’interruption non planifiée par an, sans nécessiter d’arrêt pour les mises à jour logicielles.

EN FILIGRANE : L’intégration de Spyre. Les capacités d’inférence des Power11 seront renforcées par l’intégration d’accélérateurs Spyre, un Asic optimisé pour les besoins spécifiques des charges IA d’entreprise, avec un accent sur la scalabilité, la sécurité et la fiabilité. Cela permettra un cotraitement : les charges IA sont déléguées à Spyre, tandis que le CPU Power11 gère les transactions, la sécurité et la gestion système.

À SURVEILLER : L’inférence, modestement. Avec ses nouveaux serveurs, IBM ne cible pas l'entraînement de modèles d’IA mais se concentre sur l'accélération de l'inférence, pour optimiser les processus métiers dans des secteurs comme la finance, la santé ou la distribution. Pionnière dans l’IA avec Watson, Big Blue devrait générer quelque 6 milliards de dollars de chiffre d’affaires dans l’IA cette année. Après avoir ouvert la voie au cloud computing avec le on-demand il y a presque un quart de siècle, elle ne détient aujourd’hui que 3,2 % du marché des serveurs. Il lui faudra faire mieux sur l’IA.

Anthropic, Microsoft, OpenAI

Anthropic, Microsoft, OpenAI

L’éducation américaine se forme à l’IA • Microsoft, OpenAI et Anthropic, en partenariat avec l’American Federation of Teachers et la United Federation of Teachers, viennent de lancer la National Academy of AI Instruction, un programme de formation à l’intelligence artificielle destiné à 400 000 enseignants de la maternelle au lycée sur cinq ans. Dotée de 23 millions de dollars, l’initiative prévoit des ateliers, cours en ligne et formations en présentiel à New York. Microsoft apporte 12,5 millions de dollars, OpenAI 10 millions, dont 2 en ressources techniques, et Anthropic prévoit 500 000 dollars la première année. Le programme inclura des modules généraux sur le fonctionnement de l’IA et des formations sur les outils des trois entreprises. En savoir plus…

Larvatus prodeo : DeepSeek choisit la recherche plutôt que l’audience

Larvatus prodeo : DeepSeek choisit la recherche plutôt que l’audience

Moins de six mois après avoir secoué le marché avec un modèle de langage à très bas prix, DeepSeek voit son influence s’éroder. En cause : une stratégie d’allocation des ressources focalisée sur la recherche, au détriment de l’expérience utilisateur.

Le lancement du modèle DeepSeek R1 a été perçu, cet hiver, comme un séisme dans l’écosystème de l’intelligence artificielle. Pour la première fois, un laboratoire chinois proposait un modèle en accès public dont les performances en raisonnement rivalisaient avec celles d’OpenAI, tout en affichant un prix d’utilisation jusqu’à 90 % inférieur.

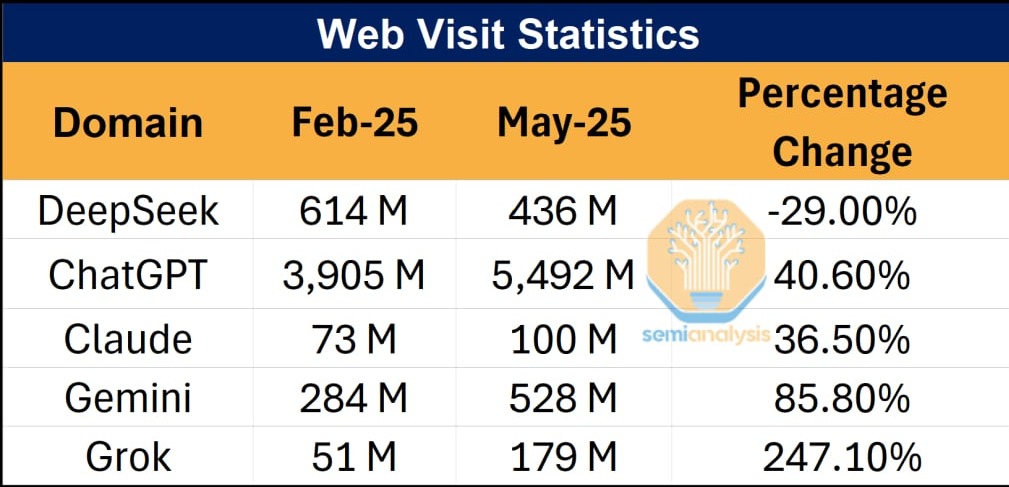

À peine cinq mois plus tard, une analyse publiée par SemiAnalysis révèle un revers de fortune apparent : la part de marché de DeepSeek s’effondre, son trafic en ligne recule, et ses propres services sont délaissés au profit de versions hébergées par des tiers.

En réalité, l’usage du modèle R1 explose sur des plateformes externes comme OpenRouter, qui propose un accès unifié à plus de 400 modèles d’intelligence artificielle (IA) provenant de plus de 60 fournisseurs. Et les entreprises chinoises déploient massivement ses modèles. Seules, les interfaces de distribution grand public – application web et API – perdent des utilisateurs, au moins à l’international.

Critères d’efficacité d’un jeton d’IA

L’explication tient en un mot, forgé par SemiAnalysis : tokenomics. Trois critères sont déterminants : la latence, c’est-à-dire le temps écoulé avant l’apparition du premier jeton ; l’interactivité, ou rapidité de génération des jetons suivants ; et la taille de la fenêtre de contexte, qui correspond à la mémoire immédiate du modèle.

Par exemple, les modèles Claude nécessitent en moyenne trois fois moins de jetons pour produire des réponses comparables à celles de DeepSeek ou Gemini, un avantage qui compense en partie la lenteur d’exécution. Cette dimension – l’intelligence par jeton – devient un facteur clé dans la compétition entre modèles.

250 millions et un plat de lentilles

250 millions et un plat de lentilles

La start-up Xpanceo, basée à Dubaï, lève 250 millions de dollars pour développer une lentille de contact intégrant vision nocturne, réalité augmentée et suivi de santé en temps réel.

Fondée en 2021 à Dubaï par le russe Roman Axelrod et l’ukrainien Valentyn Volkov, Xpanceo ambitionne de remplacer tous les appareils numériques personnels par une lentille de contact multifonction reposant sur l’intelligence artificielle, la nanophotonique et la biosurveillance.

La start-up a levé 250 millions de dollars dans une levée de fonds de série A qui valorise l’entreprise à 1,35 milliard de dollars, menée par Opportunity Venture (Asia), déjà investisseur lors de son tour de table initial de 40 millions de dollars en 2023.

Les prototypes actuels incluent des fonctions de vision nocturne, zoom optique, correction des couleurs, détection de la pression intraoculaire et analyse de biomarqueurs présents dans les larmes, comme le glucose ou les hormones.

Xpanceo prévoit de présenter un modèle prêt pour les essais cliniques d’ici fin 2026. Elle assure que ses lentilles peuvent se charger sans fil via un dispositif externe, tout en garantissant des niveaux de radiation comparables à des écouteurs classiques.

La start-up a développé 15 prototypes opérationnels en 24 mois, dont 5 présentés en février au Mobile World Congress. Elle revendique 110 publications scientifiques coécrites avec des experts internationaux.

À SURVEILLER : Tout un plat de lentilles connectées. En 2022, Samsung et la start-up américaine Inwith, avaient présenté des prototypes au CES et Mojo Vision, qui avaient levé quelque 90 millions de dollars, avait fait porter “in-eye” un premier prototype. Depuis, Mojo a jeté l’éponge mais Xpanceo reprend le projet de faire converger l’utilisation de santé (détection du glucose et de la tension oculaire, notamment) et l’usage de réalité augmentée (avec, notamment, un assistant IA permanent). En Europe, on note surtout deux medtechs, l’helvétique Sensimed, spécialisée dans le glaucome, et la belge Azalea Vision, qui a levé 9 millions d’euros ce printemps.

Comment les cryptos permettent à la Russie de contourner les sanctions

Comment les cryptos permettent à la Russie de contourner les sanctions

Face aux restrictions occidentales depuis l’invasion de l’Ukraine, la Russie a recouru aux cryptomonnaies, à l’or et à la compensation pour se doter d’un système de paiements internationaux alternatif.

Le Kremlin a rendu public, hier, un entretien entre Vladimir Poutine et le chef de Rosfinmonitoring, le service russe de surveillance financière, Yury Chikhantchine, qui expose comment les entreprises russes contournent les sanctions pour effectuer des paiements transfrontaliers.

Les échanges entre la Russie et la Chine ont bondi à 245 milliards de dollars l’an dernier mais, à cause des sanctions occidentales, les commissions de paiement peuvent atteindre 12 %.

Pour minimiser les paiements, les banques russes ont mis en place des mécanismes de compensation multilatérale et multicompte avec des tiers de confiance qui utilisent, notamment, l’or et les cryptomonnaies.

Chikhantchine considère cependant que les cryptos et l’or sont insuffisamment régulés. Un système baptisé « Transparent Blockchain » est en cours de développement avec la banque centrale et la banque VTB afin de permettre aux autorités de surveiller les transactions en cryptomonnaie, avec une mise en service prévue d’ici fin 2025.

De même, Chikhantchine demande à ce qu’un plafond soit imposé à la quantité d’or qu’un particulier ou une entreprise peut exporter.

À SURVEILLER : Les cryptos et la fragmentation du système monétaire international. Les paiements internationaux russes ont failli s’interrompre au printemps 2024, en raison de la menace de sanctions secondaires américaines contre des banques partenaires en Chine, en Inde, en Turquie et aux Émirats arabes unis. Au lieu de quoi, la Russie semble avoir réussi à créer un système alternatif, largement fondé sur les cryptos.

ReserveOne, Tether

ReserveOne, Tether

Tether double ses lingots • Tether détient environ 80 tonnes d’or, évaluées à 8 milliards de dollars, dans un coffre-fort en Suisse dont l’emplacement reste confidentiel, a déclaré son CEO Paolo Ardoino à l’agence Bloomberg. Une réserve qui représente près de 5 % de ses actifs. Principal émetteur du stablecoin USDT, adossé au dollar et en circulation à hauteur de 159 milliards de dollars, Tether stocke directement la majorité de cet or, ce qui en fait l’un des plus grands détenteurs privés du métal. En juin 2024, Tether avait lancé Alloy (lire Qant du 20 juin 2024), un stablecoin adossé à l'or et surcollatéralisé par Tether Gold (un jeton numérique adossé à des réserves physiques d’or). A ce moment-là, les réserves d'or de Tether étaient estimées à 4 milliards de dollars. En savoir plus…

Un milliard pour entasser des bitcoins • ReserveOne prévoit de s’introduire sur le Nasdaq via une fusion avec une société d’acquisition (Spac), visant une levée de plus de 1 milliard de dollars entre octobre et décembre 2025. Soutenue par Kraken et Blockchain.com à hauteur de 750 millions de dollars, l’entreprise gérera un portefeuille de bitcoins, ethers et sols, en lien avec la réserve stratégique américaine de cryptomonnaies. Elle entend prêter et “staker”ces actifs (c’est-à-dire les bloquer pour participer à la validation des transactions et obtenir des récompenses) pour générer des revenus. En savoir plus…

Reachy Mini : Hugging Face pollinise la robotique open source

Reachy Mini : Hugging Face pollinise la robotique open source

La plateforme Hugging Face ouvre les commandes de Reachy Mini, son robot issu du rachat de la française Pollen Robotics.

Hugging Face lance Reachy Mini, un robot humanoïde de 28 cm pensé comme une plateforme d’expérimentation pour l’IA embarquée, issu du rachat de la start-up française Pollen Robotics en avril dernier.

Vendu en kit et entièrement programmable, le Reachy Mini dispose de 6 degrés de liberté pour les mouvements de tête, d’écrans OLED pour les yeux, d’antennes expressives, et d’un système audio complet avec microphones et haut-parleurs.

Conçu comme un outil pédagogique et de prototypage, le robot peut être programmé en python, avec des extensions prévues en javascript et scratch ; les développeurs peuvent partager leurs applications sur la fonctionnalité communautaire Spaces.

Disponible en deux versions (avec connexion externe ou avec une carte Raspberry Pi 5 intégrée et une batterie), Reachy Mini est livré avec des démonstrations préinstallées et s’intègre à la plateforme Hugging Face Hub.

EN FILIGRANE : Robot ouvert. Reachy Mini repose sur un modèle open source intégral, incluant le matériel, le logiciel et les instructions d’assemblage, avec une monétisation fondée sur la vente de kits semi-assemblés pour les utilisateurs préférant éviter l’auto-construction.

À SURVEILLER : Le pari de Hugging Face. La robotique open source est née avec le développement de ROS (Robot Operating System) par Willow Garage en 2007 ; Hugging Face héberge désormais 1,7 million de modèles ROS ou ROS2. Après avoir lancé LeRobot en 2024 et fait l’acquisition de Pollen en 2025, la plateforme semble déterminée à faire naître le marché.

EN EXCLUSIVITÉ POUR LES ABONNÉS :

EN EXCLUSIVITÉ POUR LES ABONNÉS :

• Le laboratoire chinois DeepSeek voit la fréquentation de ses services chuter rapidement après un lancement spectaculaire, en raison d’une stratégie centrée sur la recherche au détriment de l’expérience utilisateur.

• Trois critères sont déterminants pour juger d’un modèle d’IA : la latence, c’est-à-dire le temps écoulé avant l’apparition du premier jeton ; l’interactivité, ou rapidité de génération des jetons suivants ; et la taille de la fenêtre de contexte, qui correspond à la mémoire immédiate du modèle.

DeepSeek, le géant qui choisit la recherche plutôt que l’audience

Moins de six mois après avoir secoué le marché avec un modèle de langage à très bas prix, DeepSeek voit son influence s’éroder. En cause : une stratégie d’allocation des ressources focalisée sur la recherche, au détriment de l’expérience utilisateur.

Le lancement du modèle DeepSeek R1 a été perçu, cet hiver, comme un séisme dans l’écosystème de l’intelligence artificielle. Pour la première fois, un laboratoire chinois proposait un modèle en accès public dont les performances en raisonnement rivalisaient avec celles des modèles d’OpenAI, tout en affichant un prix d’utilisation jusqu’à 90 % inférieur.

À peine cinq mois plus tard, une analyse publiée par SemiAnalysis révèle un revers de fortune apparent : la part de marché de DeepSeek s’effondre, son trafic en ligne recule, et ses propres services sont délaissés au profit de versions hébergées par des tiers.

...