Comment se préparer à l’AGI et l’ASI

OpenAI lance de nouveaux modèles, Safe SuperIntelligence lève 2 Md$ de plus et DeepMind publie sa stratégie pour encadrer l’IA générale (AGI) et l’IA supérieure aux humains (ASI) • La blockchain de JP Morgan s’élargit • L’IA géospatiale, clé d’une assurance plus résiliente • Les successeurs du Vision Pro • Bienvenue dans Qant, mardi 15 avril 2025.

« Le progrès est devant nous, à condition de dépasser sa propagande » Paul Virilio

Les promesses d’o3

Les promesses d’o3

Les futurs modèles d’OpenAI, o3 et o4-mini, devraient créer des “agents doctoraux”, susceptibles de mener des recherches scientifiques autonomes. Et dans l’immédiat, sur son API, OpenAI lance GPT-4.1 en substitution de GPT-4.5.

Le futur modèle o3 d’OpenAI, qui est dans les dernières phases de redteaming, ainsi que son successeur o4 – qui est déjà à l’entraînement –, devrait être capable de soumettre de nouvelles idées théoriques et de suggérer de nouvelles expériences scientifiques pour les valider.

Ces capacités de “recherche doctorale” ont été testées dans la fusion nucléaire, la découverte de médicaments et la recherche de nouveaux matériaux, mais elles s’étendraient également à la génération de code et au monde des affaires.

o4-mini devrait être lancé dans les jours ou les semaines à venir, ainsi qu’o3. OpenAI prévoirait de facturer ces “agents doctoraux” 20 000 dollars par mois.

Dans l’immédiat, OpenAI a ouvert hier les modèles GPT-4.1, GPT-4.1 mini et GPT-4.1 nano. Ils sont disponibles sur son API mais non via ChatGPT et disposent d’une fenêtre de contexte d’un million de tokens, à l’instar de Gemini.

Moins consommatrice d’énergie, la série GPT-4.1 remplacera GPT-4.5 sur l’API à partir du 14 juillet. Ce dernier grand modèle restera disponible pour les abonnés payants de ChatGPT.

À SURVEILLER : L’arrivée de l’AGI... Un post-doc capable de mener des recherches indépendantes ne dispose peut-être pas de '“l’intelligence générale” mais il n’en est pas très loin. Si o4 tient ses promesses, il est temps de faire taire les rieurs et se préparer à l’intelligence artificielle générale (AGI).

2 milliards de plus pour créer une superintelligence artificielle (ASI)

Le cofondateur d’OpenAI, Ilya Sutskever, a levé 2 milliards de dollars pour sa start-up Safe Superintelligence, valorisée à 32 milliards. La perspective d’une IA supérieure à l’humain se rapproche.

La start-up Safe Superintelligence (SSI), consacrée à la création de systèmes d’IA supérieurs à l’intelligence humaine, vient de lever 2 milliards de dollars sur une valorisation de 32 milliards, selon le Financial Times.

Le tour de table a été mené par Greenoaks. Parmi les investisseurs figurent également Lightspeed Venture Partners et Andreessen Horowitz.

SSI avait déjà levé 1 milliard de dollars en septembre 2024 à une valeur d’entreprise de 5 milliards.

L’entreprise a été lancée en juin 2024 (lire Qant du 21 juin 2024) par l’ancien directeur scientifique et cofondateur d’OpenAI, Ilya Sutskever – l’un des créateurs du deep learning moderne – avec Daniel Gross (ex-Apple) et le chercheur Daniel Levy.

À SURVEILLER : …L’arrivée de l’ASI. SSI se consacre à un seul objectif : le développement d’une superintelligence (ASI) sûre, sans dévoiler de détails sur sa stratégie ou son produit, encore inexistant. Certains modèles de Deepmind, comme Alphafold, sont déjà des ASI – mais le rêve qui anime SSI, tout comme Thinking Machines et OpenAI, est celui d’une intelligence artificielle générale d’un niveau supérieur à l’humain. Et leurs arguments semblent convaincants.

Le plan de DeepMind pour sécuriser l’AGI et l’ASI

Le plan de DeepMind pour sécuriser l’AGI et l’ASI

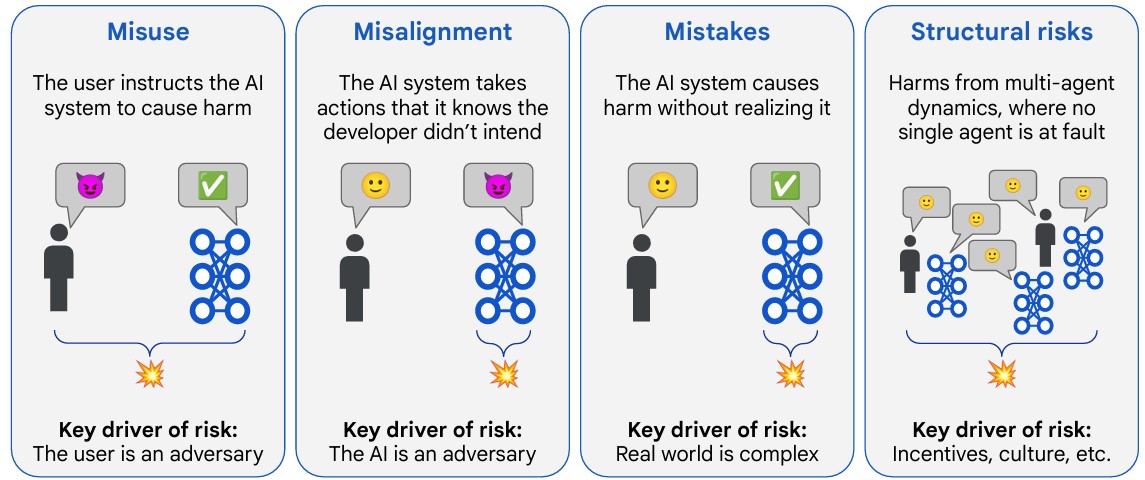

DeepMind propose un cadre technique pour prévenir les abus et les dérives des intelligences artificielles aux capacités avancées, dans une logique de précaution face aux risques sévères.

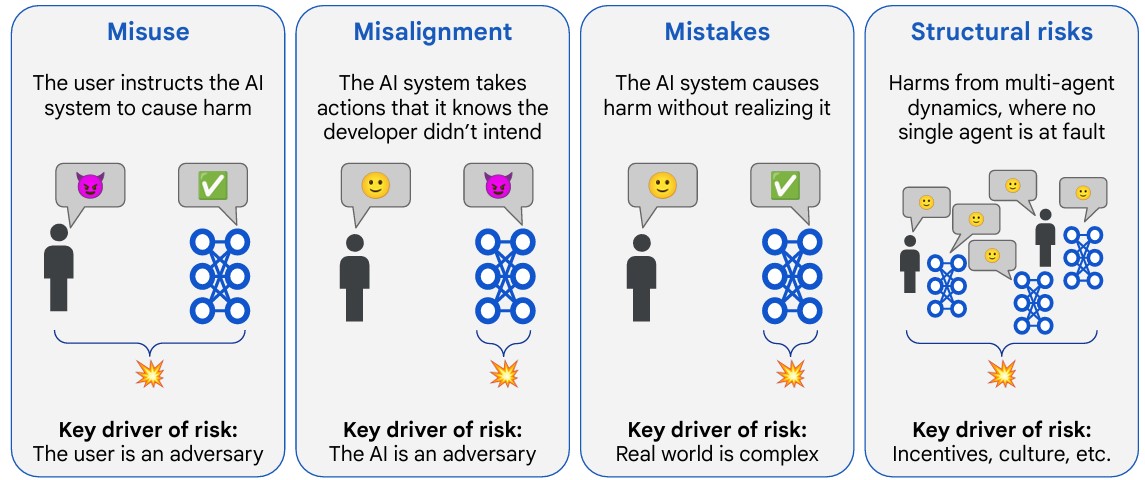

Google DeepMind a publié début avril une approche détaillée de la sécurité technique pour l’intelligence artificielle générale (AGI). Ce document s’attache à définir des mécanismes concrets visant à éviter ce que l’organisation appelle des « préjudices sévères » – des scénarios suffisamment graves pour menacer des pans entiers de l’humanité. Face à la montée en puissance attendue de modèles capables d’égaler ou de dépasser les humains dans de nombreuses tâches non physiques, l’équipe de recherche propose une feuille de route reposant sur une évaluation rigoureuse des risques et sur des principes techniques déjà compatibles avec le développement actuel des systèmes d’IA.

D’abord, DeepMind part du principe qu’il n’existe pas de plafond naturel limitant les capacités de l’IA aux performances humaines. Ensuite, les auteurs estiment plausible l’émergence de systèmes très puissants d’ici à 2030, ce qui impose des solutions rapidement mobilisables, intégrables dans les pratiques actuelles. Ils anticipent également un scénario d’accélération : des IA capables d’automatiser la recherche scientifique pourraient engendrer une boucle de progrès rapide.

Nvidia, OpenAI

Nvidia, OpenAI

Montrer patte blanche pour l’API d’OpenAI • OpenAI prévoit d’imposer une vérification d’identité pour accéder à ses futurs modèles les plus avancés via son API. Le processus, baptisé « Verified Organization », nécessitera un justificatif officiel et ne sera accessible qu’à certaines entités éligibles. Selon OpenAI, cette mesure vise à limiter les usages abusifs, après des cas de violations de ses règles d’utilisation, et à prévenir les risques de vol de données. La semaine dernière, la firme de cybersécurité SentinelOne a montré qu’AkiraBot, un réseau de spam d’origine inconnue, a utilisé pendant des mois l’API d’OpenAI avec le modèle gpt-4o-mini pour générer des messages uniques. En savoir plus…

Face à Trump, Nvidia secoue ses puces • Nvidia va fabriquer une partie de ses puces d’IA aux États-Unis, avec des sites en construction en Arizona et au Texas. La production des puces Blackwell a démarré chez TSMC à Phoenix, et des usines de “superordinateurs” seront ouvertes avec Foxconn à Houston et avec Wistron à Dallas. Objectif : produire jusqu’à 500 milliards de dollars d’infrastructures IA aux États-Unis d’ici quatre ans. En savoir plus…

Sécurité : Trump frappe SentinelOne

Sécurité : Trump frappe SentinelOne

Après avoir mis au pas les grands cabinets d’avocats, Donald Trump s’attaque aux entreprises américaines de cybersécurité.

Donald Trump a révoqué mercredi soir l’habilitation de sécurité de Chris Krebs, ancien directeur de l’agence de cybersécurité des États-Unis (la Cisa), ainsi que celles de plusieurs collaborateurs de la société SentinelOne, où Krebs occupe désormais un poste de direction.

La révocation a été ordonnée par décret présidentiel (executive order), une méthode inhabituelle, pour contourner les procédures administratives prévues par la loi.

Cette décision peut mettre en péril les contrats gouvernementaux de SentinelOne, prestataire sur des projets classifiés, malgré les déclarations rassurantes de l’entreprise sur l’impact à court terme.

Au cours de son premier mandat, Trump avait nommé Krebs à la tête de l’Agence de cybersécurité et de sécurité des infrastructures (Cisa). La rupture entre les deux hommes provient de ce que Krebs n’a jamais cautionné l’intox selon laquelle Trump aurait gagné les élections de 2020.

À SURVEILLER : L'effet sur les prestataires et éditeurs de cybersécurité. Une enquête de Reuters montre que la profession est paralysée par la violence des représailles de Donald Trump contre son ancien affidé. Outre que cela pourrait dissuader les entreprises américaines du secteur de collaborer avec l’État ou d’embaucher d’anciens hauts fonctionnaires, l’ensemble du secteur pourrait être désorganisé, baissant la garde des États-Unis contre les cyberattaques.

Otan, Palantir

Otan, Palantir

Pour l’IA, l’Otan regarde vers Palantir • L’Otan a finalisé l’acquisition du système d’IA militaire Maven Smart System (MSS NATO) développé par Palantir, destiné au Commandement allié des opérations. Cet outil d’analyse intégrant modèles de langage, IA générative et machine learning doit améliorer la fusion du renseignement, la planification et la prise de décision sur le champ de bataille. Le déploiement opérationnel est prévu d’ici 30 jours. En savoir plus…

Déjà, Waymo perce sous Uber

Déjà, Waymo perce sous Uber

Waymo représente déjà 20 % des courses Uber à Austin, profitant d’un accès exclusif à l’application pour accélérer son déploiement autonome.

Environ 20 % des courses Uber à Austin durant la dernière semaine de mars ont été assurées par les robotaxis de Waymo, selon des données rapportées par Bloomberg.

À Austin, les trajets Waymo sont uniquement accessibles via l’application Uber, contrairement à San Francisco où ils nécessitent l'application Waymo One.

Waymo a réalisé 80 % de courses autonomes en plus à Austin lors des 27 premiers jours de lancement cette année par rapport au démarrage à San Francisco l’année dernière.

À SURVEILLER : L’expansion à Atlanta. Le lancement prévu cet été utilisera exclusivement l’application Uber, poursuivant la stratégie de partenariat pour élargir l’accès aux robotaxis.

Bientôt deux nouveaux casques Apple

Bientôt deux nouveaux casques Apple

Apple développe deux nouveaux casques Vision Pro, dont un modèle connecté au Mac, en réponse aux critiques sur le prix et le poids de son premier appareil.

Apple prépare deux nouveaux modèles de Vision Pro, dont une version allégée et moins chère, ainsi qu’un casque distinct à connecter à un Mac, selon le journaliste de Bloomberg.

Le nouveau Vision Pro vise à corriger les deux défauts majeurs du modèle actuel (lire Qant du 13 juin 2023) : son prix, de 3 500 dollars, et son poids.

Le second appareil, plus simple, comportera un affichage opaque en réalité virtuelle, et devra être branché à un Mac pour fonctionner, notamment pour des usages professionnels.

À SURVEILLER : Des lunettes AR Apple. Ces développements font partie d’un plan plus large visant la création de lunettes de réalité augmentée légères, que l’on pourrait porter toute la journée. D’après Bloomberg, Tim Cook considère ces lunettes comme le prochain produit majeur d’Apple, qu’il souhaite lancer avant celles de Meta.

JPMorgan élargit Kinexys à la livre sterling

JPMorgan élargit Kinexys à la livre sterling

Dans un marché des stablecoins dominé par le dollar, la plateforme de paiements blockchain Kinexys de JPMorgan, anciennement appelée JPM Coin, prend désormais en charge les comptes en livres sterling, ainsi qu’en euros.

La plateforme Kinexys de JPMorgan, accepte désormais les comptes libellés en livres sterling pour ses clients entreprises, selon Bloomberg.

Cette extension s’ajoute à l’offre existante en dollars américains et en euros, intégrée en 2024 (lire Qant du 7 novembre 2024), sur un service actif 24 heures sur 24 pour les virements internes et les opérations de change.

Kinexys traite plus de 2 milliards de dollars de transactions par jour, soit une fraction infime du volume total de 10 000 milliards de dollars (environ 9 350 milliards d’euros) que gère quotidiennement la division paiements de JPMorgan.

À SURVEILLER : SwapAgent, filiale du London Stock Exchange, et le négociant en matières premières Trafigura, de Singapour, figurent parmi les premiers utilisateurs du service élargi.

Les assureurs doivent adopter l'IA géospatiale

Les assureurs doivent adopter l'IA géospatiale

Au lieu de reculer devant le risque, le secteur de l'assurance doit le gérer activement à l'aide d'une technologie alimentée par l'IA qui peut repérer les propriétés, les entreprises ou d'autres actifs particulièrement vulnérables aux catastrophes naturelles. Une telle approche pourrait permettre d'économiser des milliards de dollars de pertes et de protéger d'innombrables vies et moyens de subsistance.

Par Pierre du Rostu (Axa)

« L'assurance ne sert pas uniquement à indemniser les pertes (aussi important que cela puisse être), mais à protéger les vies humaines et les moyens de subsistance. En adoptant une approche de gestion des risques basée sur la technologie géospatiale, les assureurs remplissent leur mission. »

« L'escalade rapide de la crise climatique a déjà bouleversé le secteur de l'assurance. Se retirer simplement du risque n'est pas une option viable à long terme – les assureurs se condamneraient à l'insignifiance. Ils doivent au contraire s'adapter à la nouvelle donne en adoptant l'état d'esprit nécessaire pour créer un secteur avant-gardiste et technologiquement sophistiqué, capable de jouer un rôle crucial dans la construction d'un monde plus sûr et plus stable.»

EN EXCLUSIVITÉ POUR LES ABONNÉS :

EN EXCLUSIVITÉ POUR LES ABONNÉS :

• Le plan de DeepMind anticipe l’arrivée d’IA surpassant l’humain d’ici 2030 et appelle à des standards de sûreté rapidement mobilisables.

• Face à la multiplication des catastrophes naturelles, les assureurs doivent passer d’une logique d’indemnisation à une gestion proactive du risque grâce à l’IA géospatiale.

Le plan de DeepMind pour sécuriser l’AGI et l’ASI

DeepMind propose un cadre technique pour prévenir les abus et les dérives des intelligences artificielles aux capacités avancées, dans une logique de précaution face aux risques sévères.

Google DeepMind a publié début avril une approche détaillée de la sécurité technique pour l’intelligence artificielle générale (AGI). Ce document s’attache à définir des mécanismes concrets visant à éviter ce que l’organisation appelle des « préjudices sévères » – des scénarios suffisamment graves pour menacer des pans entiers de l’humanité. Face à la montée en puissance de modèles capables d’égaler ou de dépasser les humains dans de nombreuses tâches non physiques, l’équipe de recherche propose une feuille de route reposant sur une évaluation rigoureuse des risques et sur des principes techniques déjà compatibles avec le développement actuel des systèmes d’IA.

Deux priorités : abus et désalignement

...