Biais cachés et erreurs réelles

Corrigés de leurs comportements explicites, les LLM gardent des biais racistes implicites • Google lance DataGemma, un modèle pour corriger les erreurs factuelles • La Russie accélère le rouble numérique • Dubaï et Pékin s'exemptent de la protection des données pour renforcer l'IA • Bienvenue dans Qant, lundi 16 septembre 2024

« Le progrès est devant nous, à condition de dépasser sa propagande » Paul Virilio

Les biais cachés des grands modèles de langage

Les biais cachés des grands modèles de langage

Des chercheurs américains révèlent que les grands modèles de langage, comme GPT-4, manifestent des biais racistes subtils lorsqu'ils traitent des textes en anglais afro-américain.

Une étude menée par des chercheurs de l'université Stanford, de l'université de Chicago et de l'Allen Institute for AI, met en lumière la présence de préjugés racistes subtils dans les grands modèles de langage comme GPT-4. Selon cette étude publiée dans Nature, ces systèmes d'intelligence artificielle manifestent une forme de racisme voilé contre les locuteurs de l'anglais afro-américain (AAE). Ce phénomène, appelé "préjugé dialectal", apparaît sans que la race ne soit explicitement mentionnée, ce qui soulève des inquiétudes sur le rôle des IA dans la perpétuation et l'amplification des discriminations existantes.

Une Gemma pour corriger les modèles

Une Gemma pour corriger les modèles

Google a présenté DataGemma, une série de modèles d'intelligence artificielle open source, pour réduire les erreurs factuelles dans les réponses à des questions statistiques.

Ces modèles, disponibles sur Hugging Face, utilisent la base de données Data Commons, contenant plus de 240 milliards de points de données provenant de sources fiables.

DataGemma utilise deux approches pour améliorer l'exactitude : la RIG (Retrieval Interleaved Generation) et la RAG (Retrieval Augmented Generation), avec des résultats significatifs en tests préliminaires.

À SURVEILLER. La mise à disposition de DataGemma intervient peu après la remise en ligne de la génération d’images par Gemini. Les avancées de Google en matière de “factualité” et de précision des modèles d'intelligence artificielle pourraient avoir un fort impact, notamment dans les secteurs économiques et scientifiques.

Et par ailleurs :

Et par ailleurs :

La Maison-Blanche a obtenu l'engagement de plusieurs entreprises d'intelligence artificielle comme Anthropic, Cohere, Microsoft ou OpenAI, pour lutter contre la création et la diffusion de contenus pornographiques non consensuels, notamment les deepfakes, en supprimant les images explicites de leurs bases de données et en adoptant des mesures de sécurité. En savoir plus…

Des chercheurs du MIT et de Cornell ont découvert que des chatbots utilisant des modèles de langage IA peuvent réduire la croyance en des théories du complot d'environ 20% en engageant des conversations personnalisées et convaincantes avec les individus, en adaptant leurs arguments aux croyances spécifiques de chaque personne. En savoir plus…

Glean Technologies, une plateforme d’IA générative B2B, partenaire notamment de Zendesk et Salesforce, a levé plus de 260 millions de dollars (235 M€) lors d'un tour de financement de série E, valorisant l'entreprise à 4,6 milliards de dollars (4,2 Md€). En savoir plus…

L'avantage des pays autoritaires en matière d'IA

L'avantage des pays autoritaires en matière d'IA

Par Angela Huyue Zhang

Angela Huyue Zhang, professeur de droit à l'université de Californie du Sud, est l'auteur de High Wire : How China Regulates Big Tech and Governs its Economy (Oxford University Press, 2024).

On attribue souvent le développement rapide des technologies d'IA dans des pays comme les Émirats arabes unis et la Chine au soutien de l'État et à l'énergie bon marché. Mais un autre facteur est important : leur modèle de gouvernance autoritaire, qui permet aux entreprises d'IA d'entraîner leurs modèles sur de grandes quantités de données personnelles.

“Les analystes attribuent souvent l'émergence des Émirats arabes unis en tant que puissance de l'IA à plusieurs facteurs, notamment un soutien solide de l'État, des capitaux abondants et une électricité à bas prix, autant d'éléments nécessaires à la formation des LLM. Mais un autre facteur important – et souvent négligé – est le modèle de gouvernance autoritaire du pays, qui permet au gouvernement de tirer parti du pouvoir de l'État pour stimuler l'innovation technologique.»

« Les pays autoritaires comme la Chine disposent d'un avantage concurrentiel intégré en matière de développement de l'IA, en grande partie en raison de leur dépendance à l'égard de la surveillance nationale, qui alimente la demande. Les technologies de reconnaissance faciale, par exemple, sont utilisées par ces régimes non seulement pour renforcer la sécurité publique, mais aussi comme de puissants outils pour surveiller leurs populations et réprimer la dissidence.»

Le rouble numérique se rapproche à grands pas

Le rouble numérique se rapproche à grands pas

La Banque centrale de Russie prévoit l'adoption généralisée du rouble numérique d'ici juillet 2025, en commençant par les plus grandes banques du pays. Ces banques devront permettre à leurs clients d'ouvrir des comptes en roubles numériques, de les approvisionner et de faire des transferts.

D'autres banques plus petites suivront progressivement, avec pour objectif de rendre le rouble numérique accessible à tous, au même titre que l'argent liquide et les fonds non monétaires.

À SURVEILLER. La Russie et la Chine comptent parmi les pays dont les monnaies numériques sont les plus avancées, dans la tentative de dédollariser les échanges internationaux.

Et par ailleurs :

Et par ailleurs :

Malgré la conversion de Donald Trump aux cryptos ce printemps, tous les conservateurs américains n’ont pas viré de bord. Le groupe de protection des consommateurs Consumers' Research , qui se consacre à combattre l’ESG et les “sociétés woke”, dénonce depuis le mois de juin le manque de transparence de Tether concernant ses réserves en dollars. Un nouveau rapport, Tether Warning, souligne l'absence d'un audit complet du premier stablecoin au monde, dont la circulation approche des 120 milliards de dollars (107 Md€). Et il accuse l’USDT de faciliter les activités illicites. En savoir plus…

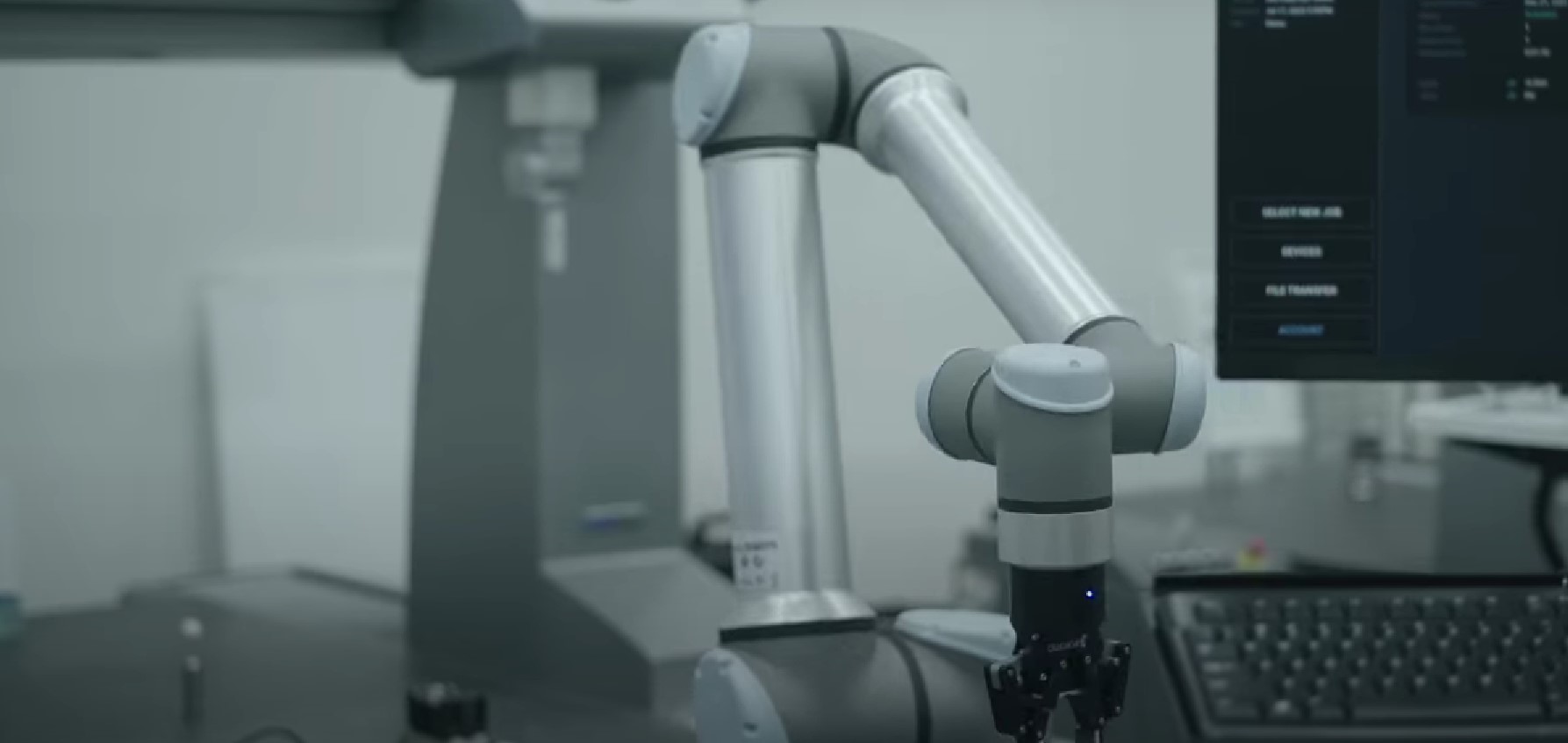

Un robot tactile pour inspecter les usines

Un robot tactile pour inspecter les usines

Pionniers de la première vague, les robots industriels semblent désormais bien peu innovants désormais. Une start-up de Boston fondée en 2018, Flexxbotics, essaie de prouver le contraire. Après avoir lancé une plateforme qui connecte robots, dispositifs d’automatisation et systèmes d’information, elle vient de s’associer à une start-up issue du MIT, GelSight, pour proposer un système d’inspection non destructive (NDT). Celui-ci interprète les relevés d’une “peau” artificielle (l’elastomère de GelSight). Disposée sur n’importe quelle surface, elle est capable de créer une topologie extrêmement précise, mesurant des défauts d’une taille d’un micron.

EN EXCLUSIVITÉ POUR LES ABONNES :

EN EXCLUSIVITÉ POUR LES ABONNES :

• Les LLM montrent des préjugés racistes implicites en réponse aux textes en anglais afro-américain, affectant des décisions cruciales comme l'attribution d'emplois.

• Les pays autoritaires comme les Émirats arabes unis et la Chine se distinguent dans le développement de l'IA grâce à leur gouvernance, qui facilite l'accès aux données personnelles et la collaboration entre entreprises et gouvernements.

• GelSight et Flexxbotics présentent un système qui combine détection tactile et robotique pour automatiser les inspections, réduisant ainsi les temps d'arrêt et augmentant la précision des processus.

Les biais cachés des grands modèles de langage

Une étude révèle que les grands modèles de langage, comme GPT-4, manifestent des biais racistes subtils lorsqu'ils traitent des textes en anglais afro-américain.

...