Après Deepseek, Alibaba

Alibaba lance des modèles d'IA dont les fenêtres de contexte atteignent 1 million de tokens • Meta personnalise son IA • Humanity Protocol avance sur des solutions d’identité Web3 sécurisées • LG s’offre Bear Robotics • Une IA pour passer au crible la jurisprudence française • Bienvenue dans Qant, mercredi 29 janvier 2025.

Qant: Révolution cognitive et Avenir du numérique

7 min ⋅ 29/01/2025

« Le progrès est devant nous, à condition de dépasser sa propagande » Paul Virilio

Alibaba monte à l’assaut

Alibaba monte à l’assaut

Alibaba a dévoilé une batterie de nouveaux modèles, qui complètent la série open-source Qwen et se veulent meilleurs que DeepSeek et Llama.

Deux des nouvelles versions de la gamme de modèles open source Qwen 2.5 d’Alibaba, Qwen2.5-7B-Instruct-1M et Qwen2.5-14B-Instruct-1M, prennent en charge des fenêtres de contexte qui atteignent 1 million de tokens.

Jusqu’à présent, seul Gemini se targuait de pouvoir accepter un contexte aussi long (jusqu’à 2 millions de tokens), quoique des extensions existent pour porter à ce niveau la fenêtre d’attention de Llama 3 (Gradient) et Mistral 7B (InfLLLm).

Les nouveaux Qwen utilisent une technique appelée attention sparse, qui sélectionne uniquement les parties les plus pertinentes du contexte pour optimiser le traitement des informations. Cette approche réduit la charge de calcul, et permet de traiter des données longues jusqu’à sept fois plus rapidement qu’avec des méthodes classiques.

Alibaba a également présenté Qwen2.5-VL, qui combine capacités de compréhension multimodale et interactions avec des applications sur PC et mobile.

Les tests présentés montrent que Qwen2.5-VL surpasse des modèles comme GPT-4o ou Claude 3.5 Sonnet sur des tâches comme l’analyse de vidéos, la reconnaissance d’objets et la gestion de documents complexes.

EN FILIGRANE : Alibaba a été le premier, et avant DeepSeek le seul, à présenter des modèles chain-of-thought open source susceptibles de rivaliser avec OpenAI o1, dès novembre 2024 : Qwen With Questions (QwQ) et Marco-o1. Le groupe propose une gamme complète de modèles, principalement open source, mais avec une licence restreinte aux entreprises de moins de 100 millions d’utilisateurs actifs mensuels (contre 700 millions pour Meta). Trois modèles payants et propriétaires sont hébergés sur Alibaba Cloud.

À SURVEILLER : La séquence chinoise. Depuis l’investiture de Donald Trump, Pékin a tiré trois coups de semonce : la fermeture de TikTok pendant 24h, les prouesses économiques DeepSeek R1 et maintenant la démonstration de puissance IA d’Alibaba. L’administration Trump semble encore en train de chercher la réponse.

La jurisprudence française au crible de l’IA

La jurisprudence française au crible de l’IA

Une nouvelle étude propose un cadre pour l’utilisation de l’intelligence artificielle pour analyser les décisions judiciaires.

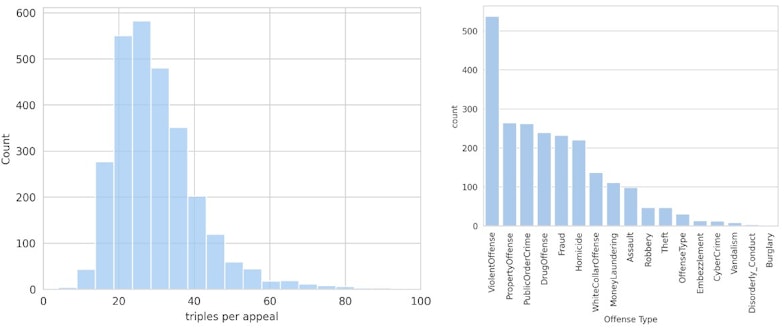

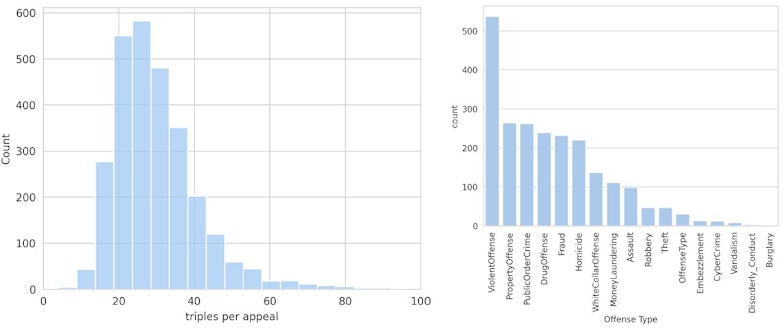

Le chercheur-entrepreneur Alexander Belikov (GrowGraph) et Sacha Raoult, de l’université Aix-Marseille, viennent de prépublier un article de recherche qui détaille une méthode pour construire des graphes de connaissances à partir de décisions de justice non structurées, en utilisant des modèles de langage de grande taille (LLM). Ils présentent un cadre intégrant une ontologie spécifique au domaine du droit pénal français et exploitent la base de données Judilibre.

Deux approches sont comparées : l'utilisation de graphes de propriétés et de triplets RDF (Resource Description Framework), la seconde démontrant une plus grande précision. L'étude évalue la performance du système, met en évidence l'importance de l'ontologie, et discute des applications potentielles, notamment l'analyse statistique et prédictive. Le travail souligne l'efficacité des LLM pour extraire et structurer des informations complexes à partir de documents juridiques.

Grok, Manas AI, Meta

Grok, Manas AI, Meta

Meta AI se basera sur vos profils sociaux • Meta vient d'annoncer une mise à jour de son chatbot Meta AI, désormais capable de personnaliser ses réponses grâce aux données des utilisateurs issues de Facebook et Instagram. Le modèle analysera les préférences de l’utilisateur, comme un régime alimentaire ou des centres d’intérêt, pour offrir des recommandations adaptées. Disponible aux États-Unis et au Canada, cette évolution ne manquera pas de soulever en Europe des questions sur la gestion des données personnelles. En savoir plus…

Manas, l’IA qui combat le cancer • Reid Hoffman, fondateur de LinkedIn, et Siddhartha Mukherjee, chercheur en oncologie, viennent de cofonder Manas AI, une start-up dédiée à la découverte de médicaments par l’IA. Avec un financement initial de 24,6 millions de dollars, l’entreprise se concentrera sur les cancers du sein, de la prostate et les lymphomes, en s’appuyant sur Microsoft Azure pour ses recherches. En savoir plus…

Grok3 en avant-première • D’après le blogueur berlinois Alexey Shabanov, qui s’est introduit au sein du prochain modèle d’IA d’Elon Musk, le lancement du nouveau modèle devrait avoir lieu la semaine prochaine. Le system prompt, qui fixe les lignes de comportement du modèle, contient notamment, d’après Shabanov, un rappel que le 47ème président des États-Unis est bien Donald Trump. Pour éviter toute distraction. En savoir plus…

LG accélère dans les robots

LG accélère dans les robots

Le géant sud-coréen LG Electronics a acquis 51 % de Bear Robotics, une start-up californienne spécialisée dans les robots serveurs autonomes, pour créer une plateforme logicielle commune à tous ses robots.

LG Electronics a annoncé avoir porté sa participation dans Bear Robotics à 51 %, prenant ainsi le contrôle de la start-up californienne. L’investissement supplémentaire, estimé à environ 180 millions de dollars, valorise l’entreprise à 600 millions de dollars. Fondée en 2017 par John Ha, ancien ingénieur logiciel chez Google, Bear Robotics s’appuie sur des technologies d’intelligence artificielle pour contrôler des flottes de robots et gérer des systèmes à distance.

L’objectif est de créer une plateforme logicielle commune pour harmoniser les fonctions des robots commerciaux, industriels et domestiques tout en accélérant leur développement. LG prévoit notamment de lancer cette année le Q9 AI Home Hub, un robot autonome capable de reconnaître les voix, les sons et les images. Ce robot se connecte aux appareils domestiques via l’Internet des objets (IoT) et utilise une technologie de reconnaissance vocale développée avec Microsoft.

Humanity Protocol veut s’attaquer à Sam Altman

Humanity Protocol veut s’attaquer à Sam Altman

La plateforme d'identité décentralisée Humanity Protocol lève 20 millions de dollars pour développer des solutions biométriques basées sur la blockchain. Elles concurrenceront celles de World Network, l’ancienne Worldcoin, cofondée par le CEO d’OpenAI.

Humanity Protocol a obtenu 20 millions de dollars lors d'un tour de table mené par Pantera Capital et Jump Crypto, portant sa valorisation à 1,1 milliard de dollars.

Fondée en 2024, la plateforme développe le Proof of Humanity, qui associe un scan de paume à une identité numérique sur les plateformes Web3.

Les fonds levés financeront le lancement imminent de son mainnet et un airdrop de jetons en partenariat avec OKX Wallet.

À SURVEILLER : Fond de l’œil et empreintes digitales. Concurrent de World Network, Humanity Protocol se différencie par des scans de paume jugés moins intrusifs que les scans d'iris, tout en assurant un haut niveau de sécurité. Ce ne sera sans doute pas le seul facteur de décision pour la création d’un état-civil universel sur la blockchain.

EN EXCLUSIVITÉ POUR LES ABONNES :

EN EXCLUSIVITÉ POUR LES ABONNES :

• En créant des graphes de connaissances à partir des décisions des tribunaux, l’IA ouvre de nouvelles perspectives pour la recherche juridique.

• LG rachète une start-up de robotique californienne pour créer une plateforme logicielle unique pour ses robots.

La jurisprudence française au crible de l’IA

Une nouvelle étude propose un cadre pour l’utilisation de l’intelligence artificielle pour analyser les décisions judiciaires.

Le chercheur-entrepreneur Alexander Belikov (GrowGraph) et Sacha Raoult, de l’université Aix-Marseille, viennent de prépublier un article de recherche qui détaille une méthode novatrice pour construire des graphes de connaissances à partir de décisions de justice non structurées, en utilisant des modèles de langage de grande taille (LLM). Ils présentent un cadre intégrant une ontologie spécifique au domaine du droit pénal français et exploitent la base de données Judilibre.

Deux approches sont comparées : l'utilisation de graphes de propriétés et de triplets RDF (Resource Description Framework), la seconde démontrant une plus grande précision. L'étude évalue la performance du système, met en évidence l'importance de l'ontologie, et discute des applications potentielles, notamment l'analyse statistique et prédictive. Le travail souligne l'efficacité des LLM pour extraire et structurer des informations complexes à partir de documents juridiques.

L’objectif principal de cette recherche est de transformer des documents juridiques complexes et non structurés en graphes de connaissances exploitables. Ces graphes permettent de relier entre elles des entités et leurs relations, comme les infractions, les condamnations, ou les peines infligées.

La base de données utilisée, Judilibre, regroupe des décisions judiciaires françaises dans un format anonymisé. Chaque document contient des informations détaillées sur les faits reprochés, les décisions des tribunaux, les recours et les sanctions. La richesse de ces données en fait une ressource précieuse, mais leur structuration manuelle est une tâche laborieuse. C’est là que l’intelligence artificielle peut intervenir.

Une approche technologique innovante

...