Du traitement de l’IA dans la presse et l'administration

Mistral souffle sur France Travail • Anthropic renforce la constitution de Claude • Ethereum augmente sa capacité de transactions • L’IA détecte à grande échelle le cancer du sein et transforme les capacités de manipulation des robots • La presse sous-estime l’impact environnemental de l’IA • Bienvenue dans Qant, mercredi 5 février 2025.

Qant: Révolution cognitive et Avenir du numérique

7 min ⋅ 05/02/2025

« Le progrès est devant nous, à condition de dépasser sa propagande » Paul Virilio

Mistral pointe à France Travail (ou l’inverse)

Mistral pointe à France Travail (ou l’inverse)

L’agence publique et la start-up française annoncent un partenariat pour intégrer l’intelligence artificielle dans l’accompagnement des demandeurs d’emploi.

France Travail utilise désormais les modèles de Mistral AI pour deux outils d’intelligence artificielle : ChatFT, un robot conversationnel dédié à l’assistance à la rédaction, et MatchFT, conçu pour aider les conseillers dans leurs échanges avec les candidats.

MatchFT permettra d’envoyer des SMS aux candidats présélectionnés afin d’évaluer leur intérêt pour une offre et leurs disponibilités.

À SURVEILLER : L’effet Lucie et le risque Kafka.Déjà expérimenté dans 87 agences, MatchFT est en test depuis plusieurs mois, tandis que ChatFT a été utilisé par 23 000 agents. “L’effet Lucie”, où le système s’écroule lors de la mise en production (lire Qant du 28 janvier), devrait donc pouvoir être évité. En revanche, le risque de la dépersonnalisation des services auprès d’un public fragile reste entier.

Anthropic met Claude à l’épreuve

Anthropic met Claude à l’épreuve

Le grand rival d’OpenAI lance un test public pour évaluer la résistance de son modèle Claude face aux tentatives de jailbreak.

Anthropic a mis en place un nouveau système baptisé Constitutional Classifiers, un filtre basé sur des règles en langage naturel qui analyse les requêtes des utilisateurs et les réponses du modèle pour bloquer les contenus interdits avant qu’ils ne soient générés.

Ce système s'appuie sur l’approche "constitutionnelle" d’Anthropic, qui définit les contenus autorisés et interdits. Il utilise des classificateurs entraînés sur des prompts générés de manière synthétique et modifiés pour ressembler à des techniques connues de jailbreak.

Depuis août 2024, Anthropic a soumis son modèle à un programme de bug bounty, offrant 15 000 dollars à quiconque réussirait un "jailbreak universel" en contournant totalement ses protections. Malgré 3 000 heures d’essais par 183 experts, personne n’a encore réussi à franchir complètement la barrière.

Une évaluation interne menée sur 10 000 prompts d’attaque a montré que son système réduit le taux de succès des jailbreaks à 4,4 %, contre 86 % sur un modèle non protégé.

Anthropic reconnaît néanmoins des limites : ce bouclier augmente de 23,7 % la consommation de calcul et bloque parfois des questions légitimes. Ces faux positifs ont été réduits dans les versions récentes.

À SURVEILLER : Le test public de Claude. Jusqu’au 10 février, Anthropic invite les utilisateurs à tenter de contourner ses protections, afin d’identifier de potentielles failles et renforcer la sécurité de son modèle.

La tache aveugle de la presse face à l’IA

La tache aveugle de la presse face à l’IA

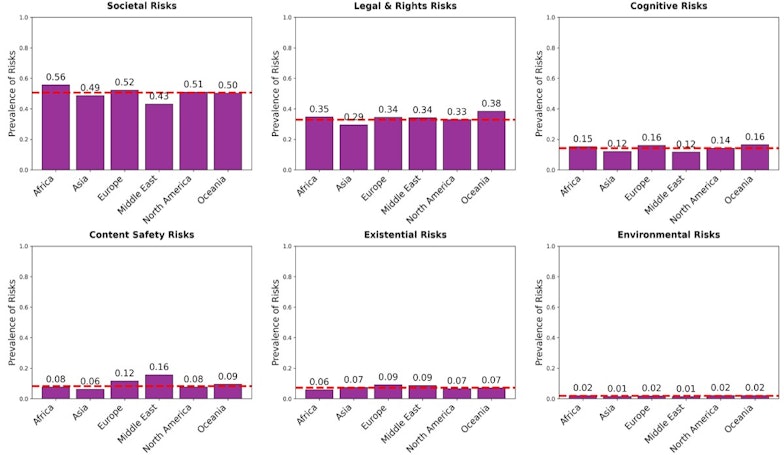

Le traitement de l’IA évolue fortement dans la presse mondiale, selon son pays d’origine et son orientation politique. Mais un grand problème est absent partout : l’impact environnemental de l’IA.

Une étude récente menée par des chercheurs de l’université Northwestern et de l’Institut du droit de l’information d’Amsterdam a analysé 42 000 articles de presse publiés dans 27 pays pour identifier les principales préoccupations liées à l’IA. L’étude classe ces risques en six grandes catégories : sociétaux, juridiques et relatifs aux droits, cognitifs, liés à la sécurité des contenus, existentiels et environnementaux.

Les risques sociétaux dominent largement le traitement médiatique, représentant plus de la moitié des articles étudiés. En revanche, l’absence de débat sur les questions environnementales pourrait freiner la mise en place de restrictions sur la consommation énergétique des modèles d’IA.

Selon les chercheurs, qui n’incluent pas les réseaux sociaux dans leur enquête, cette hiérarchisation des risques dans le discours médiatique risque d’entraîner des politiques déséquilibrées, où certaines préoccupations sont amplifiées, tandis que d’autres restent marginales.

Ils prêtent visiblement encore beaucoup d’influence aux journaux.

Kakao, Meta, NHS, OpenAI

Kakao, Meta, NHS, OpenAI

Meta s’inspire de l’AI Act • Le Frontier AI Framework, un cadre de sécurité pour l’IA que Meta vient de publier, définit des critères pour limiter ou interrompre le développement de systèmes jugés trop risqués – à l’instar des niveaux déterminés par l’AI Act européen, entré en vigueur dimanche. L’entreprise distingue les modèles "à haut risque", pouvant faciliter des cyberattaques ou la prolifération d’armes biologiques, et ceux "à risque critique", dont l’impact serait catastrophique et incontrôlable. Contrairement à des tests quantitatifs, Meta s’appuie sur l’évaluation d’experts internes et externes pour classer ces risques. En savoir plus…

En Grande-Bretagne, l’IA détecte le cancer du sein à grande échelle • Le NHS britannique lance le plus grand essai mondial de diagnostic du cancer du sein par intelligence artificielle, visant à analyser 700 000 mammographies en Angleterre. Cinq modèles d’IA examineront 462 000 scans, tandis que les 238 000 restants seront évalués selon la méthode traditionnelle par deux radiologues, afin de comparer les résultats. Financé à hauteur de 11 millions de livres (environ 12,8 M€), cet essai s’inscrit dans un nouveau plan national contre le cancer. En savoir plus…

OpenAI boit du Kakao en Corée • OpenAI a annoncé un partenariat stratégique avec Kakao, géant technologique sud-coréen, pour intégrer son intelligence artificielle dans l’écosystème de KakaoTalk, l’application de messagerie la plus populaire du pays. L’accord prévoit le développement de Kanana, un assistant vocal en coréen basé sur les modèles d’OpenAI, ainsi que l’utilisation de ChatGPT Enterprise par les employés de Kakao. Cet accord s'inscrit après celui déjà signé avec SoftBank au Japon, illustrant l'expansion rapide d'OpenAI en Asie. En savoir plus…

Ethereum ouvre le gaz

Ethereum ouvre le gaz

Ethereum a relevé sa limite de transactions au-delà de 30 millions d’unités de “gaz”, impactant directement la capacité du réseau à traiter les transactions et exécuter des smart contracts.

Ethereum a atteint un consensus permettant d’augmenter la limite de gaz du réseau, fixée depuis 2021 à 30 millions d’unités. La limite de gaz définit la quantité maximale de calculs qu’un bloc peut contenir.

52 % des validateurs ont soutenu cette modification, une première depuis la transition vers la preuve d’enjeu.

Cela entraîne une hausse automatique de la limite, qui dépasse désormais 31,5 millions et pourrait atteindre 36 millions.

Cette évolution vise à accroître la capacité de transactions du réseau principal tout en évitant les frais élevés, malgré les récents gains de scalabilité.

À SURVEILLER : le fork Pectra. Prévu pour mars, il vise à améliorer la scalabilité d’Ethereum en augmentant la capacité de stockage des données temporaires utilisées par les solutions de layer 2, réduisant ainsi les frais de transaction.

L’extrême précision du robot fouettard

L’extrême précision du robot fouettard

Des chercheurs de l’université de Berkeley ont développé une méthode d’apprentissage qui permet aux robots d’acquérir des compétences avancées de manipulation, grâce à l’intelligence artificielle, au renforcement par l’expérience et à l’intervention humaine.

L’équipe du laboratoire Robotic AI and Learning Lab de l’université de Californie à Berkeley a présenté en octobre dernier une approche combinant intelligence artificielle, apprentissage par renforcement et corrections humaines. Les robots commencent par assimiler les bases d’une tâche, puis s’améliorent grâce à l’expérience et aux retours fournis par des capteurs et caméras. Les résultats viennent d’être rendus publics.

EN EXCLUSIVITÉ POUR LES ABONNÉS :

EN EXCLUSIVITÉ POUR LES ABONNÉS :

• L’IA est couverte différemment selon les régions et l’orientation politique des médias, influençant ainsi le débat public et la régulation.

• Un nouveau modèle d’apprentissage permet aux robots d’exécuter des gestes complexes avec une grande précision, en combinant IA et ajustements en temps réel par un opérateur.

La tache aveugle de la presse face à l’IA

Le traitement de l’IA évolue fortement dans la presse mondiale, selon son pays d’origine et son orientation politique. Mais un grand problème est absent partout : l’impact environnemental de l’IA.

Une étude récente menée par des chercheurs de l’université Northwestern et de l’Institut du droit de l’information d’Amsterdam a analysé 42 000 articles de presse publiés dans 27 pays pour identifier les principales préoccupations liées à l’IA. L’étude classe ces risques en six grandes catégories : sociétaux, juridiques et relatifs aux droits, cognitifs, liés à la sécurité des contenus, existentiels et environnementaux.

Chouchou des médias

...